Codificação

Compressão Espacial

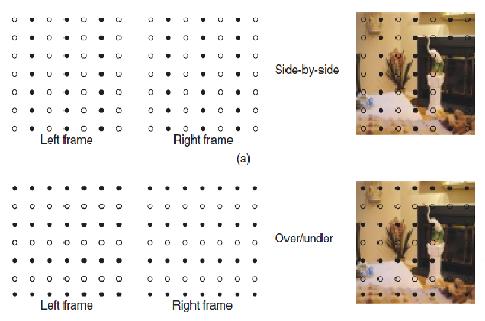

O operador entrega o conteúdo 3D stereo sobre um sinal 2D HD, usando a largura de banda deste. Existe perda de resolução tanto para o olho esquerdo como para o direito. O objetivo será compactar duas imagens numa única trama, o dispositivo do cliente (box), irá tornar a imagem num efeito 3D. Os métodos mais comuns de compressão espacial são a combinação side-by-side e a over/under. Na aproximação side-by-side são retiradas colunas adjacentes de pixels da imagem, sendo a segunda imagem embutida side-by-side. Na versão over/under, são retiradas linhas adjacentes, sendo a segunda imagem embutida nestas linhas de pixels. Será no fundo entremear uma imagem com outra, como é óbvio a qualidade será 50% inferior.

Multiplexagem Temporal

A multiplexagem temporal dobra o frame rate de 50 para 100 Hz, permitindo a representação sequencial tanto para o olho esquerdo como para o direito numa frame rate normal de 50 Hz. Este método apresenta a resolução total para cada olho, no entanto ocupa o dobro da largura de banda.

Compressão para vídeo stereo convencional (CSV)

A norma Moving Picture Experts Group (MPEG)-2 contém um método de codificação MPEG-2 Multi View Profile (MVP) que combina explora uma redundância espacial e temporal entre as duas imagens. Esta norma foi melhorada com a introdução do suplemento stereo Supplemental Enhancement Information (SEI), já na norma H.264, este permite usar o conceito de predição para compressão. Embora não tendo sido inicialmente desenhada para este efeito, a ferramenta pode ser reorganizada para tirar partido das redundâncias entre um par de vistas stereo. Este método permite a compatibilidade inversa, um televisor 2D pode descodificar a informação apresentando apenas a informação relativa à imagem esquerda do par stereo. Apenas são enviadas frames I na vista esquerda de modo a aproveitar a redundância espacial. Em termos de acesso basta enviar frames I na imagem relativa à vista direita.

Video + Profundidade (V+D)

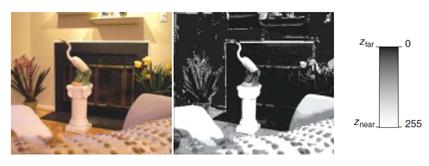

Mais recentemente surgirão algumas propostas para abandonar o antigo conceito estereoscópio para a captação e visualização de imagens 3D. O novo conceito visa a captura de imagens num sistema de 2 sinais em que o primeiro capta um sinal de vídeo manoscópico e o segundo um sinal de profundidade, associando a profundidade matricialmente ao vídeo pixel a pixel. Desta forma pode ser gerada uma vista virtual 3D do lado do utilizador usando métodos de Depth Image Based Rendering(DIBR). Este sistema torna possível a compatibilidade inversa com sistemas 2D, além de uma importante escalabilidade em diversos tipos de equipamentos distintos. A informação pixel a pixel para a profundidade pode ser considerada uma luminância monocromática com um intervalo compreendido entre [Znear, Zfar], esta informação é quantizada com 8 bits variando de 0 a 255.

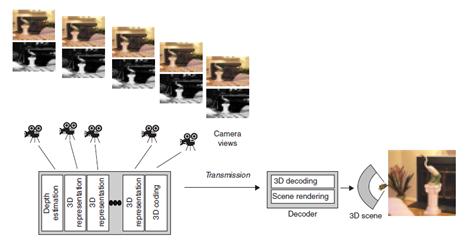

Multiview Video + Profundidade (MV+D)

O sistema multiview aqui descritopretende codificar a informação obtida por várias câmaras que se encontram a filmar o mesmo alvo. Expandindo o vetor de câmaras disponíveis, é possível teoricamente uma melhor experiência 3D para o utilizador final. Os sistemas Multiview Video Coding (MVC) e V+D não conseguem lidar com a informação proveniente de uma grande quantidade de câmaras, daí o grupo MPEG começou a desenvolver esforços no intuito de criar uma norma que suporte estes requerimentos, baseados no sistema MV+D. Este sistema utiliza alguns passos complexos, a profundidade tem que ser estimada a partir das N vistas no ponto de captura, o sinal com a cor N com a profundidade N tem que ser codificado e transmitido, no descodificador, a informação tem que ser descodificada e as várias vistas virtuais precisam de ser reconstruidas. Usando este método a compressão será cerca de 30% para N=2 e de 25% para N>2.